LocalAI-自主托管与OpenAIAPI规范兼容并支持多种语言模型

May 16, 2023

前言

本文简单记录介绍一下LocalAI。

LocalAI支持自主托管和运行,与OpenAI API规范兼容,支持多种模型。

正文

一、什么是LocalAI

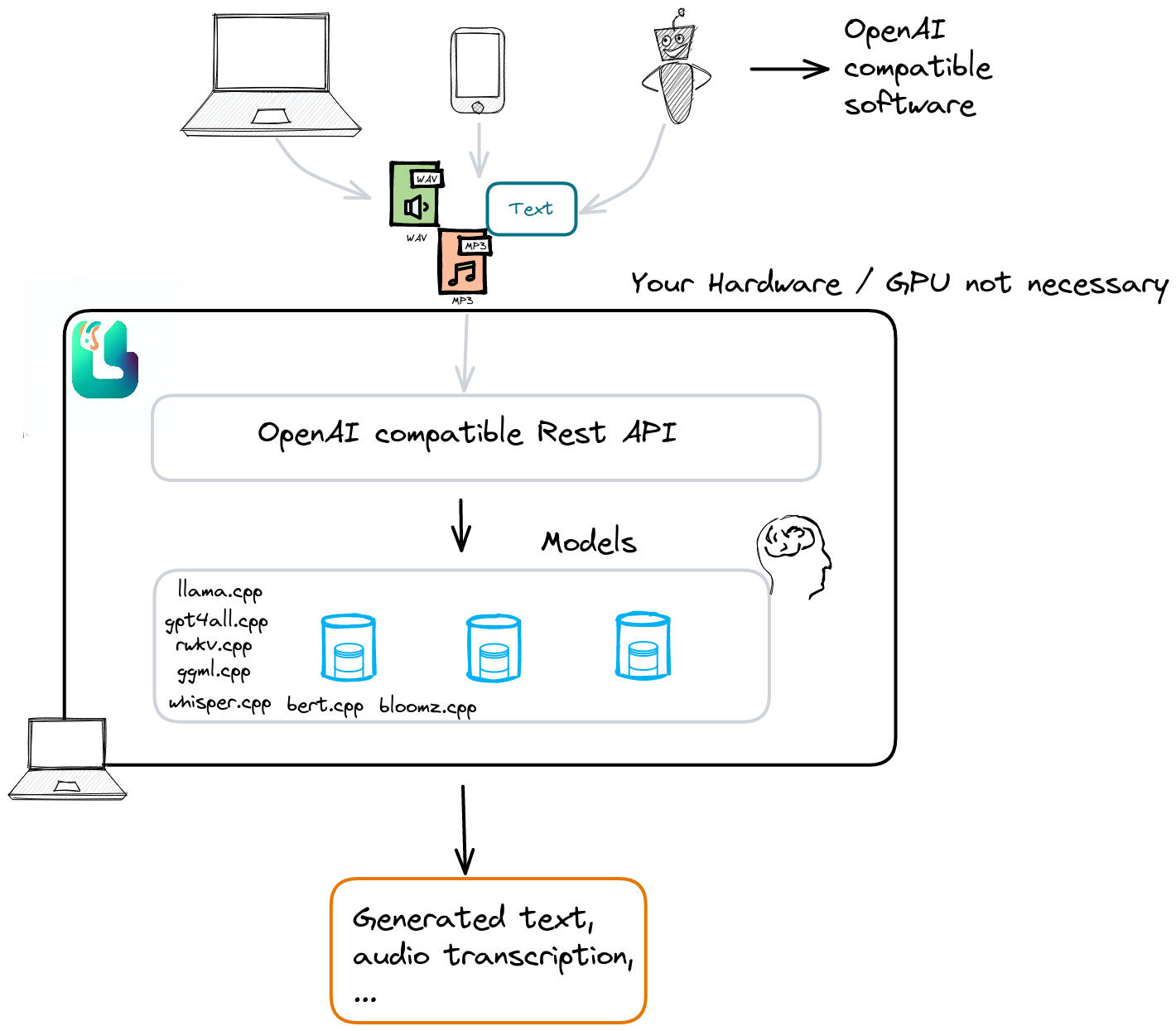

LocalAI是一个本地AI API,可以自主托管和运行模型,与OpenAI API规范兼容,支持多种模型。

二、LocalAI功能

LocalAI有以下主要功能:

- 兼容OpenAI的REST API规范,可以作为本地推理的OpenAI替代方案;

- 支持多个模型系列,如llama.cpp, gpt4all, rwkv.cpp, ggml, whisper.cpp和bert.cpp;

- 加载一次后,将模型加载到内存中,以获得更快的推断速度;

- 支持prompt templates,提供更多的填写选项;

- 使用C++绑定,以获得更快的推断速度。

下面是官方项目目前支持的模型列表:

三、部署LocalAI

可以使用docker-compose快速启动LocalAI,也可以通过构建本地镜像来使用LocalAI。LocalAI的具体用法可以参考文档Usage和examples中的使用案例。

以下是一段示例代码:

1 | # Clone LocalAI |

四、总结

LocalAI可以将本地模型部署成OpenAI API的接口形式,可以很方便的集成到目前各种流行的应用当中,避免了个人数据上传OpenAI或Microsoft等其他云端模型,适合折腾的人部署。

缺点是需要本地硬件足够支持运行这些语言模型。

最后

参考文章:

声明

本文仅作为个人学习记录。

本文永久记录于区块链博客xlog。