SALT-基于SAM的通用标注工具

May 18, 2023

前言

本文简单记录介绍一下SALT的使用情况。

SALT是基于Meta最近发布的Segment-Anything模型来标记图像并以COCO格式保存标注数据的通用标注工具。

正文

一、SALT介绍

SALT基于Segment-Anything模型实现标记图像并以COCO格式保存标注数据,得益于SAM的强大分割能力,可以帮助标注者更轻松精确的标注想要的任何实体。

二、SALT安装

- 安装sam(环境要求

python>=3.8,pytorch>=1.7以及torchvision>=0.8)

1 | git clone https://github.com/facebookresearch/segment-anything.git |

安装好后,下载默认模型参数:vit-h,放置到自定义位置。

- 安装salt

1 | git clone https://github.com/anuragxel/salt.git |

- 转换数据集

准备好待标注的数据集dataset,将图片放入dataset/images,并新建文件夹dataset/embeddings;

运行命令:

1 | python helpers/extract_embeddings.py --checkpoint-path “自定义的sam模型参数文件路径” --dataset-path “待标注的数据集路径” |

- 转换模型

运行命令:

1 | python helpers/generate_onnx.py --checkpoint-path “自定义的sam模型参数文件路径” --onnx-models-path “自定义转换的onnx模型文件路径” --dataset-path “待标注的数据集路径” |

- 开始标注

1 | python segment_anything_annotator.py --onnx-models-path “自定义转换的onnx模型文件路径” --dataset-path “待标注的数据集路径” --categories “需要标注的对象列表,比如cat,dog” |

三、SALT使用

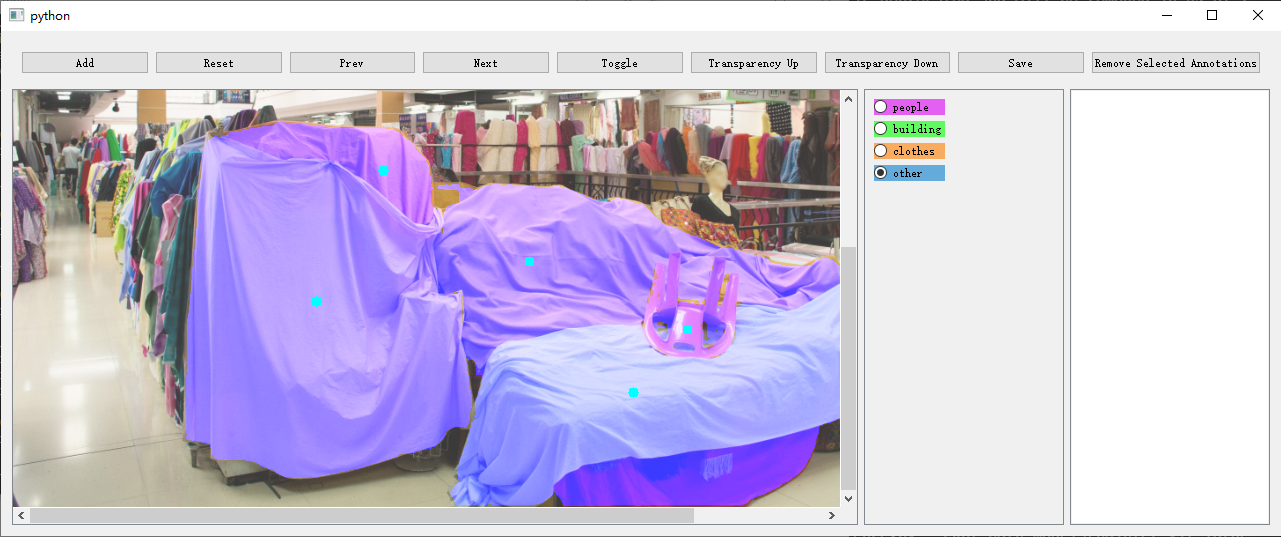

标注家具

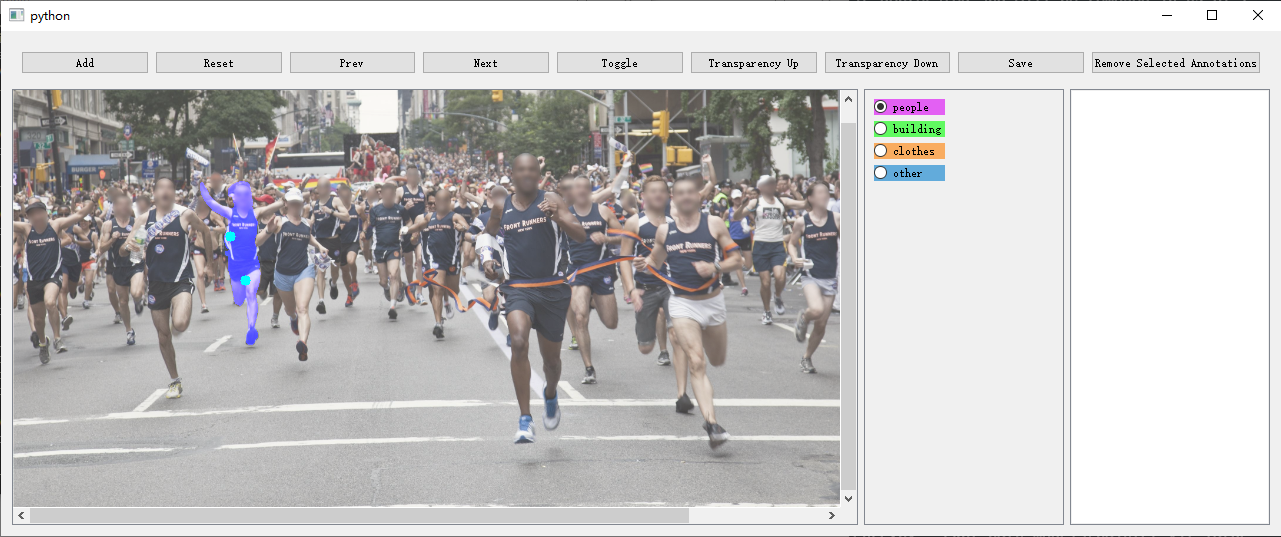

标注人物

四、总结

安装使用上没有难度,需要本地有块6G以上显存的显卡。

标注效果比手动标注更精确更快速,可以实现点击标注,框选标注等。

题外话:Meta发布了相当多有价值的项目,包括SAM,DINOv2和”泄露”的LLaMa语言模型等等,还有深度学习研究必备的Pytorch。

最后

参考文章:

声明

本文仅作为个人学习记录。

本文永久记录于区块链博客xlog。