HQTrack-高性能视频对象跟踪和分割的框架

Aug 15, 2023

前言

本文简单记录介绍一下HQTrack。

HQTrack是一个用于高性能视频目标跟踪和分割的框架。

正文

一、HQTrack介绍

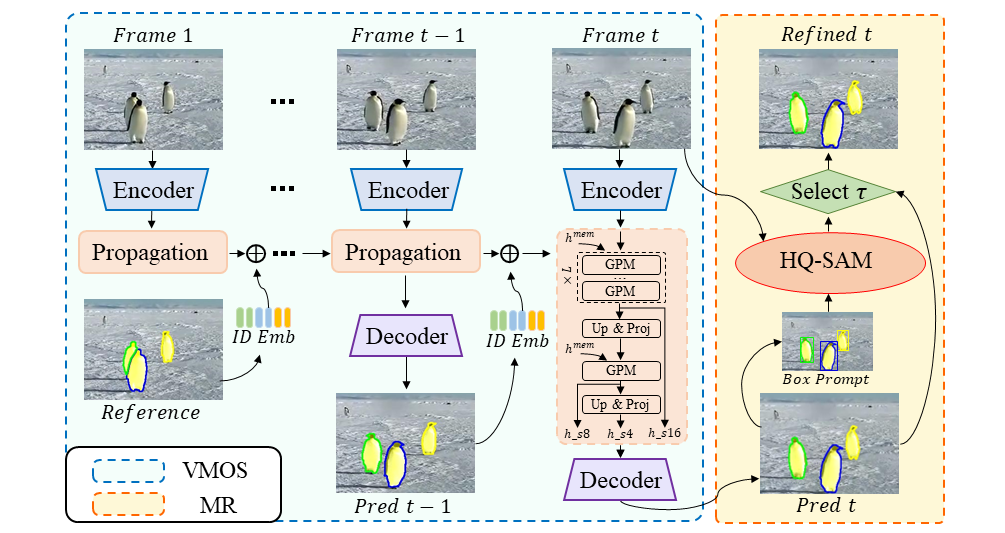

一个用于高性能视频目标跟踪和分割的框架,可以同时跟踪多个目标对象并输出准确的对象掩码。

二、HQTrack使用

1、下载项目:git clone https://github.com/jiawen-zhu/HQTrack.git

2、安装环境依赖:

在官方给的要求基础上对部分库的版本进行修改,否则无法安装成功:

pytorch需要1.10.0以上,才能安装DCNv3,并且使用DCNv3项目官方预编译好的wheel文件进行安装

gcc需要7.3.0以上,用于编译vot-toolkit框架

1 | # 安装虚拟环境 |

3、下载预训练模型

- 下载VMOS模型,解压放置到项目目录的

result/default_InternT_MSDeAOTL_V2/YTB_DAV_VIP/ckpt/内 - 下载HQ-SAM模型,放置到项目目录的

segment_anything_hq/pretrained_model/内

4、运行demo

在demo/your_video中添加想要处理的图片序列,修改demo/demo.py脚本中demo_video参数为自定义的文件夹名,运行以下命令,开始手动标记第一帧中需要追踪的对象,按r开始处理图片序列

1 | cd demo |

三、总结

项目实现了高精度的物体跟踪主要依赖于HQ-SAM,HQ-SAM使SAM具备准确分割任何对象的能力,同时保持SAM原有的提示设计、效率和零样本泛化能力。在SAM 的预训练模型权重基础上只引入了少量的额外参数和计算。

最后

参考文章:

声明

本文仅作为个人学习记录。

本文永久记录于区块链博客xlog。